Comprendre un nouveau projet GitHub en quelques minutes grâce à l’IA, sans fouiller des heures dans du code mal documenté ? C’est ce que propose DeepWiki-Open. En scrollant sur X, je suis tombé sur cet outil et en creusant un peu le sujet, j’ai découvert une histoire assez intéressante que je voulais partager.

D’où ça sort ?

Cognition AI et Devin

Derrière ce projet, il y a d’abord Cognition AI, une startup californienne fondée en 2023. En mars 2024, ils sortent Devin, présenté comme “le premier ingénieur logiciel IA totalement autonome”. Le truc fait le buzz, les investisseurs affluent, et aujourd’hui Cognition AI est valorisée à 10,2 milliards de dollars. Parmi leurs clients : Goldman Sachs, Dell, Cisco, Palantir…

Bref, c’est du lourd.

Mai 2025 : DeepWiki, le “Wikipédia du code”

Fort de ce succès, Cognition lance en mai 2025 un nouvel outil : DeepWiki.

Le concept est simple mais puissant : vous prenez n’importe quelle URL GitHub, vous remplacez github.com par deepwiki.com, et vous obtenez un wiki complet généré par l’IA avec :

- Une documentation structurée du projet

- Des diagrammes d’architecture automatiques

- Un assistant IA pour poser des questions sur le code

Pour lancer le service, Cognition a mis les moyens : ils ont indexé plus de 50 000 repositories parmi les plus populaires de GitHub, analysé 4 milliards de lignes de code, et dépensé environ 300 000 dollars en puissance de calcul juste pour cette phase d’indexation.

L’objectif affiché ? Créer un “Wikipédia du code” pour démocratiser la compréhension des projets open-source.

Le hic ? C’est un service SaaS. Gratuit pour les repos publics, mais payant dès que vous voulez analyser des repos privés (il faut un compte Devin). Et surtout, vos données passent par leurs serveurs.

L’alternative open-source : DeepWiki-Open

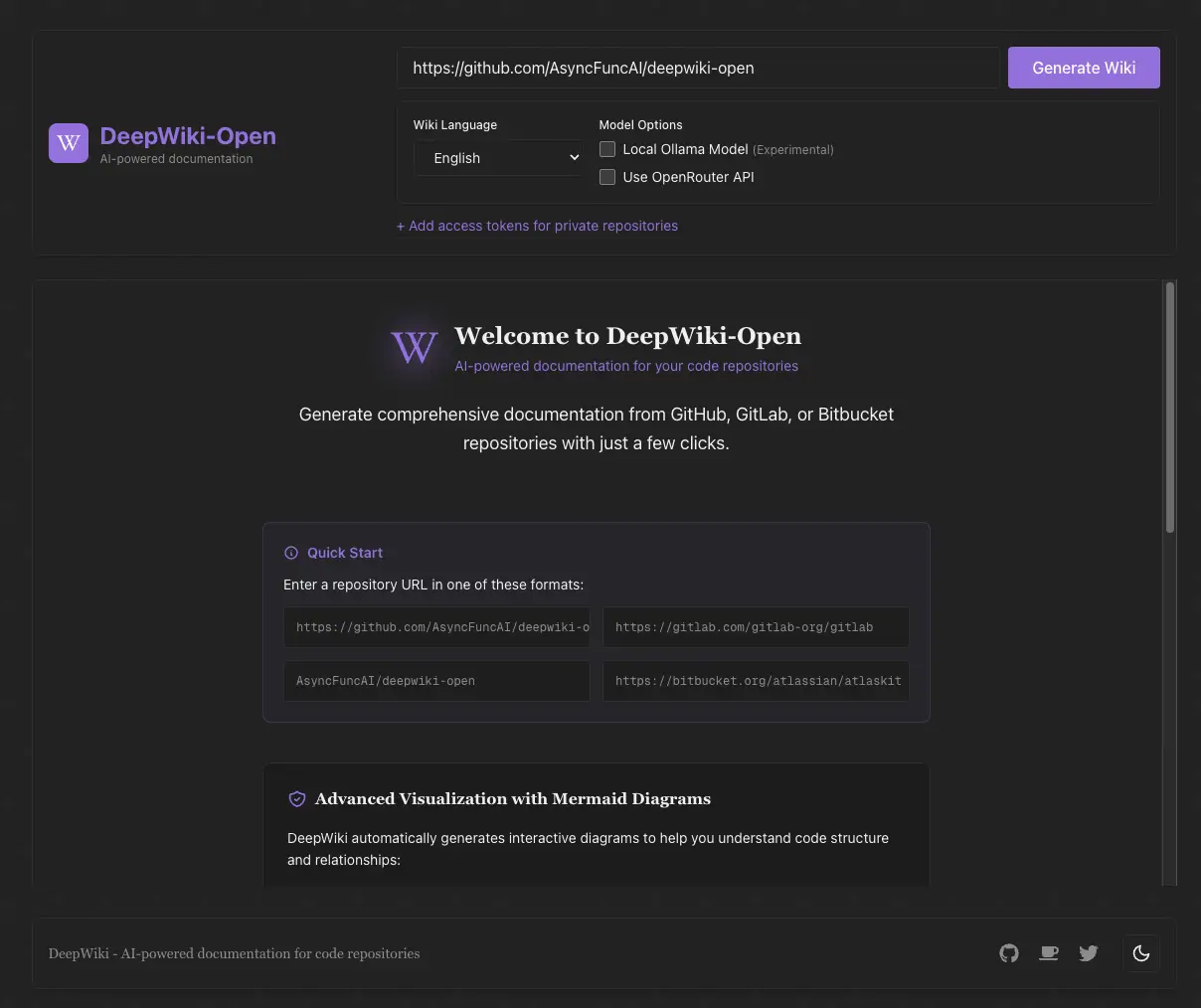

C’est là qu’entre en scène AsyncFuncAI, une petite équipe qui s’est dit : “Le concept est génial, pourquoi ne pas en faire une version open-source ?”

Dans leur README, ils décrivent le projet comme “my own implementation attempt of DeepWiki” — leur propre tentative d’implémentation.

Et le résultat est plutôt réussi : plus de 12 800 stars sur GitHub, une communauté active (Discord, contributions régulières), et surtout la possibilité de tout faire tourner chez soi.

Les vraies différences avec le DeepWiki de Cognition :

- Vous pouvez self-host la solution

- Vous utilisez vos propres clés API (OpenAI, Google, etc.)

- Ou mieux : vous pouvez tourner 100% en local avec Ollama — gratuit, privé, aucune donnée qui sort de votre machine

C’est une belle illustration de ce que l’écosystème open-source sait faire : prendre un concept innovant et le rendre accessible à tous.

DeepWiki-Open, c’est quoi concrètement ?

En résumé

Un générateur de documentation automatique pour vos repos Git, propulsé par l’IA, avec une interface de chat intégrée pour poser des questions sur le code.

Comment ça fonctionne

Le workflow est assez simple :

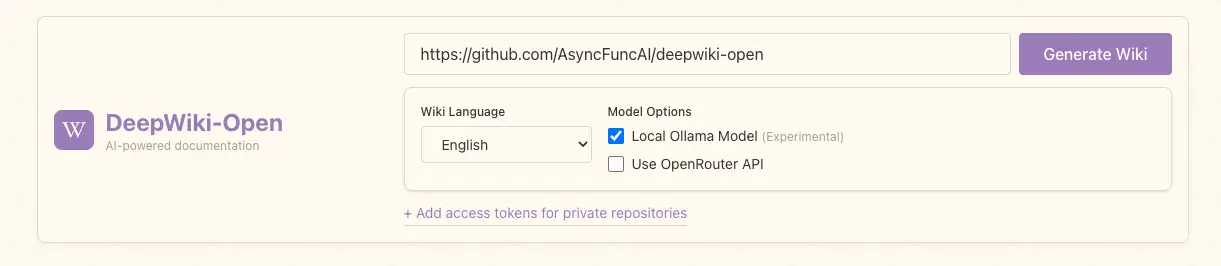

- Vous rentrez l’URL d’un repository (GitHub, GitLab, ou Bitbucket)

- DeepWiki-Open clone le repo

- L’IA analyse le code et crée une sorte d’index intelligent qui lui permet de comprendre comment chaque partie du projet est connectée aux autres.

- Elle détermine automatiquement la structure optimale du wiki

- Chaque page est générée avec du contexte récupéré via RAG

- Vous pouvez ensuite chatter avec le code !

Les fonctionnalités principales

- Documentation instantanée : transforme n’importe quel repo en wiki en quelques minutes

- Support des repos privés : via des tokens d’accès personnels

- Diagrammes automatiques : génération de diagrammes Mermaid pour visualiser l’architecture et le flux de données

- Fonction “Ask” : un chat pour poser des questions sur le code et obtenir des réponses contextuelles

- Mode “Deep Research” : pour les analyses plus poussées, avec plusieurs itérations de recherche automatiques

Les providers LLM supportés

DeepWiki-Open est flexible côté modèles IA :

| Provider | Modèles |

|---|---|

| Gemini 2.5 Flash, Pro, etc. | |

| OpenAI | GPT-4o, GPT-5, etc. |

| OpenRouter | Accès à Claude, Llama, Mistral et plein d’autres |

| Azure OpenAI | Pour les environnements entreprise |

| Ollama | Modèles locaux (llama3, etc.) — 100% offline |

La possibilité d’utiliser Ollama est vraiment intéressante pour ceux qui veulent garder le contrôle total sur leurs données.

Installation

Prérequis

- Docker & Docker Compose

- Au choix : une clé API (Google, OpenAI…) OU Ollama installé en local

Option 1 : Avec des APIs cloud

C’est la méthode la plus rapide pour tester. Vous avez juste besoin d’une clé API Google ou OpenAI.

# Cloner le repo

git clone https://github.com/AsyncFuncAI/deepwiki-open.git

cd deepwiki-open

# Créer le fichier .env

echo "GOOGLE_API_KEY=votre_clé_google" > .env

echo "OPENAI_API_KEY=votre_clé_openai" >> .env

# Lancer avec Docker Compose

docker-compose up -dEt voilà, l’interface est accessible sur http://localhost:3000 ! 🎉

Option 2 : 100% local avec Ollama

Si vous voulez que rien ne sorte de votre machine :

# Configurer pour Ollama

echo "DEEPWIKI_EMBEDDER_TYPE=ollama" > .env

echo "OLLAMA_HOST=http://localhost:11434" >> .env

# Utiliser l'image Docker avec Ollama intégré

docker build -f Dockerfile-ollama-local -t deepwiki-ollama .

docker run -p 8001:8001 -p 3000:3000 \

-v ~/.adalflow:/root/.adalflow \

deepwiki-ollamaPourquoi utiliser DeepWiki-Open ?

- Comprendre un nouveau projet avant de le déployer ou d’y contribuer — fini les heures à fouiller dans du code mal documenté

- Documenter ses propres projets sans se prendre la tête à rédiger manuellement

- Onboarder quelqu’un sur un codebase existant — vous lui partagez le wiki généré et c’est parti

- Explorer des projets open-source pour apprendre comment ils sont structurés

- Analyser des repos privés/sensibles en local, sans envoyer votre code sur des serveurs tiers

Les limites

Soyons honnêtes, l’outil n’est pas parfait :

- Temps de génération : sur les gros repos, ça peut prendre plusieurs minutes voire plus

- Qualité variable : la doc générée dépend beaucoup de la qualité du code source — code propre = meilleure doc

- Coût en tokens : si vous utilisez des APIs cloud sur de gros projets, la facture peut grimper

- Ressources locales : avec Ollama, il faut une machine correcte (GPU recommandé)

- Pas infaillible : l’IA peut parfois mal interpréter des logiques complexes. Une relecture humaine reste pertinente pour les cas critiques

Conclusion

DeepWiki-Open répond à un vrai problème : la doc manquante ou obsolète dans les projets. Le fait de pouvoir tout faire tourner en local avec Ollama est un vrai plus. Le projet est actif, la communauté grandit, c’est clairement un outil à surveiller voire à implémenter chez vous ou même dans votre entreprise si elle est “IA-Friendly” !

Si vous cherchez une solution pour mieux comprendre les projets sur lesquels vous travaillez ou que vous découvrez, je vous recommande d’y jeter un œil !

Liens utiles :